Essai: Évaluer la sensibilité des machines

Publié le 23 juin 2022 par Andrew Owen (15 minutes)

Je m’intéresse depuis longtemps au domaine connu sous le nom d’intelligence artificielle (IA). Aujourd’hui, je préfère le terme “apprentissage machine” (car nous comprenons si peu ce qu’est réellement l’intelligence que nous ne savons pas comment la simuler). Suite à l’affirmation d’un ingénieur de Google selon laquelle son projet LaMDA a atteint la sensibilité, j’ai pensé qu’il valait la peine de dépoussiérer un essai que j’ai écrit sur le sujet lorsque j’étais étudiant de premier cycle (avant que les réseaux neuronaux et les données volumineuses ne deviennent monnaie courante).

Il est beaucoup plus facile de voir, au moins dans certains cas, quelles seront les limites du possible à long terme, parce qu’elles dépendent de la loi naturelle. Mais il est beaucoup plus difficile de savoir quel chemin nous suivrons pour nous rapprocher de ces limites. “*-K. Eric Drexler

Dans son livre de 1986 Minds, Brains and Science, John Searle déclare: “Au fur et à mesure que les ordinateurs deviennent de plus en plus compliqués, il devient de plus en plus difficile de comprendre ce qui se passe à l’intérieur d’eux. Avec des gigaoctets de mémoire vive et l’accès à des bases de données comprenant la quasi-totalité du savoir humain, il n’est pas inconcevable qu’un projet de recherche puisse devenir fou… qu’un virus puisse s’épanouir au-delà de l’imagination la plus folle de son créateur… qu’un programme conçu pour unifier l’information puisse commencer à apprendre à partir de l’information qu’il a compilée”

Cette vision de l’intelligence des machines a largement séduit un public inconscient des réalités technologiques, nourri de science-fiction cyberpunk et paranoïaque à l’idée que les ordinateurs puissent envahir le monde. Dans son livre, Searle s’attache principalement à réfuter cette notion d’ordinateurs numériques pensants (à l’exception d’autres types d’ordinateurs, peut-être encore à inventer). Le problème de savoir si les ordinateurs sont capables ou non de penser réside en partie dans notre manque de compréhension de ce qu’est réellement la pensée. Ainsi, son premier thème est “combien nous savons peu de choses sur le fonctionnement du cerveau, et combien la prétention de certaines théories dépend de cette ignorance”.

De manière détournée, Searle inclut en fait d’autres types d’ordinateurs. Il a affirmé qu’une copie parfaite du cerveau qui a la même apparence et fonctionne de la même manière n’est qu’une simulation. Searle admet que l’esprit du titre ne peut pas être très bien défini, que le fonctionnement des cerveaux n’est pas encore tout à fait clair et que toute discipline dont le nom contient le mot “science” n’en est probablement pas une. Notamment, l’une d’entre elles qui l’est, à toutes fins utiles, est l’informatique.

Searle commence par définir le problème corps-esprit. Roger Penrose, lauréat du prix Nobel de physique, déclare: “Dans les discussions sur le problème corps-esprit, il y a deux questions distinctes sur lesquelles l’attention est généralement portée: Comment se fait-il qu’un objet matériel (un cerveau) puisse réellement évoquer la conscience et, inversement, comment se fait-il qu’une conscience, par l’action de sa volonté, puisse réellement influencer le mouvement (apparemment déterminé physiquement) d’objets matériels? Searle ajoute la question suivante: “Comment devrions-nous interpréter les travaux récents en informatique et en intelligence artificielle - travaux visant à créer des machines intelligentes? Plus précisément, l’ordinateur numérique nous donne-t-il la bonne image de l’esprit humain?

Searle rejette la vision dualiste selon laquelle le monde physique, régi par les lois de la nature, est séparé du monde mental, régi par le libre arbitre. Il définit quatre phénomènes mentaux qui constituent les processus du cerveau: la conscience, l’intentionnalité, la subjectivité et la causalité. Il déclare: “Tous les phénomènes mentaux […] sont causés par des processus qui se déroulent dans le cerveau […]. Les douleurs et autres phénomènes mentaux ne sont que des caractéristiques du cerveau”. Il entend par là que toute expérience a lieu dans l’esprit, par opposition au message physique externe. Il donne l’exemple d’un patient qui subit une opération. Il est sous anesthésie et donc, dans sa vision de la réalité, il ne souffre pas du couteau du chirurgien. L’action physique est là, mais la conséquence mentale est supprimée.

Searle aborde successivement les quatre conditions nécessaires à l’analyse de l’esprit. Il explique que la conscience implique “certaines activités électrochimiques spécifiques entre les neurones ou les modules de neurones”. Il explique que l’intentionnalité, les pulsions et les désirs peuvent, dans une certaine mesure, être prouvés (dans le cas de la soif, par exemple). Il montre que les états mentaux subjectifs existent “parce que je suis maintenant dans l’un d’eux et que vous l’êtes aussi”. Et il montre que dans la causalité mentale, les pensées donnent lieu à des actions.

Cela nous ramène à la deuxième question de Penrose. Si l’esprit est un logiciel par rapport au matériel du corps, il n’est pas si difficile de voir comment fonctionne la causalité mentale. Ni l’esprit ni le logiciel n’ont de présence tangible. L’esprit est contenu dans la matrice du cerveau comme un logiciel est contenu dans la “mémoire” d’un ordinateur. Pourtant, une pensée peut entraîner une action, comme lever un bras, parce que des signaux physiques sont envoyés, comme un logiciel enverrait des signaux physiques par l’intermédiaire d’un ordinateur pour lever le bras d’un robot. Une extension de ce raisonnement donne naissance à la notion de possibilité d’intelligence informatique.

Le fil conducteur du livre est la tentative de Searle de contrer les affirmations des partisans de l’IA forte selon lesquelles il est possible d’apprendre aux ordinateurs à penser. Cette affirmation peut être facilement réfutée si l’on admet que l’on n’apprend pas aux humains à penser, mais les partisans de l’intelligence des machines affirment qu’ils apprennent aux ordinateurs à apprendre. Ils considèrent l’IA comme la prochaine étape de l’évolution de l’ordinateur vers l’objectif ultime de la conscience. Searle affirme que l’ordinateur numérique tel que nous le connaissons ne sera jamais capable de penser, quelle que soit sa vitesse ou la quantité de “mémoire” dont il dispose.

Au cours de l’été 1956, un groupe d’universitaires s’est réuni au Dartmouth College pour explorer la conjecture selon laquelle “chaque aspect de l’apprentissage ou toute autre caractéristique de l’intelligence peut en principe être décrit avec une telle précision qu’une machine peut être fabriquée pour le simuler”. Cette conjecture a été formulée par John McCarthy, et le domaine de recherche qu’elle a engendré est devenu l’intelligence artificielle. Le problème, selon Searle, est que les caractéristiques de l’intelligence ne peuvent pas être définies avec précision par les experts en informatique dans le domaine de l’intelligence artificielle, qui finissent par ignorer au moins l’un des quatre états mentaux pour faire fonctionner leurs programmes. Ces programmes gagnent ensuite en crédibilité en étant utilisés par la psychologie pour décrire le comportement de l’esprit humain. Searle souligne qu’à l’époque où le télégraphe était la technologie la plus récente, on pensait que le cerveau fonctionnait ainsi.

“Il y a deux façons de penser à la façon dont une machine pourrait se rapprocher de l’intelligence humaine. Dans le premier modèle, l’objectif est d’obtenir le même résultat qu’un être humain, bien que le processus suivi par la machine et l’homme ne soit pas nécessairement similaire. (Ce modèle de résultat commun, mais de processus distinct, décrit la manière dont les ordinateurs effectuent les calculs arithmétiques). Dans le second modèle, l’objectif n’est pas seulement que l’ordinateur parvienne au même résultat qu’une personne, mais qu’il le fasse en suivant la même procédure”.

Les partisans de l’IA forte estiment qu’avec les mêmes informations qu’un être humain, un ordinateur, en suivant un processus défini, pourrait dériver le même sens. Cependant, Searle soutient qu’il n’existe pas de processus distinct dans l’esprit humain qu’un ordinateur pourrait simuler, et qu’un ordinateur ne peut donc pas avoir de sens, l’une des cinq composantes du langage humain. “Dans le cas des êtres humains, chaque fois que nous suivons une règle, nous sommes guidés par le contenu réel ou la signification de la règle.

“Le langage n’est pas tant une chose qu’une relation. Parler de mots ou de phrases n’a aucun sens si les mots et les phrases ne signifient pas quelque chose. Pour que les phrases signifient quelque chose, leurs composants doivent être liés de manière ordonnée. Une expression linguistique doit être codée sur un support quelconque - comme la parole ou l’écriture - pour que nous sachions qu’elle existe. Enfin, il faut que des personnes soient impliquées dans tout cela pour produire et recevoir des messages linguistiques.

Ainsi, le langage humain se compose de cinq éléments interdépendants: le sens (ou la sémantique), le lien (ou la syntaxe), le support, l’expression et les participants”. Searle affirme qu’il ne peut y avoir de sens dans la compréhension du langage par un ordinateur, parce qu’elle repose sur une forme de jugement ou d’opinion. On pourrait également soutenir que ce que l’ordinateur reçoit n’est pas en fait un message linguistique, mais une instruction sur la manière de réagir.

Dans une certaine mesure, il est possible de jouer avec la syntaxe: Les règles de grammaire ne sont pas respectées, vous pouvez ; on comprendra toujours que vous le ferez. Le “sens” est transmis, et peut-être qu’un ordinateur qui examine les mots individuellement pourrait encore déduire le “sens”. Cependant, si nous changeons la phrase en: “Pouvez-vous enfreindre les règles de grammaire ; serez-vous toujours compris?”, le “sens” a changé. Les mots sont les mêmes, mais l’ordre et le sens sont différents. La première phrase est une affirmation, et il existe des langues qui ont cette forme grammaticale, comme le touvan, tandis que la seconde est clairement une question. Comment un ordinateur peut-il déduire le “sens” si nous n’incluons pas le “point d’interrogation”?

Searle a déjà avancé cette idée dans son argument de la chambre chinoise. Des caractères chinois sont transmis dans une pièce, où un non-chinois suit un ensemble de règles et donne une réponse qui est ensuite transmise. Searle affirme qu’il n’y a pas d’esprit dans la pièce. Les partisans de l’IA forte affirment que l’esprit fonctionne comme la pièce. Cela ne semble pas être le cas si l’on s’en tient aux quatre états mentaux de Searle. Si tel était le cas, la machine analytique de Charles Babbage (un ordinateur mécanique) aurait été capable de penser si elle avait été construite. L’argument de l’ordinateur numérique est que la technologie n’a pas d’importance, comme dans une voiture, vous pouvez changer le moteur, mais elle fonctionne toujours de la même manière.

C’est ce que montre le roman de William Gibson et Bruce Sterling “The Difference Engine”, dans lequel l’ère de l’informatique arrive avec un siècle d’avance. Dans cette version de l’histoire, Babbage perfectionne sa machine analytique et les ordinateurs à vapeur de la révolution industrielle comprennent “des canons à calcul, des dreadnoughts à vapeur, des mitrailleuses et des technologies de l’information”.

Comme le souligne Searle, les ordinateurs suivent des règles. Nous n’avons pas de règles à suivre. Si c’était le cas, tous les êtres humains auraient la même apparence et fonctionneraient de la même manière. Un cerveau serait la copie conforme d’un autre. Comme tous les cerveaux sont uniques (en particulier dans le cas de jumeaux identiques), il est clair qu’il n’y a pas de règle absolue pour les construire. Ils grandissent. Comment faire grandir un ordinateur numérique?

John McCarthy pense que son thermomètre a des sentiments. Si l’on considère le corps humain comme une machine et l’esprit comme une partie de cette machine, il semble évident que les machines ne peuvent pas éprouver de sentiments puisqu’elles n’ont pas de “récepteurs sensoriels”. Elles peuvent disposer de dispositifs d’entrée tels que l’audio, la vidéo, le spectre thermique ou autre. Le fait est que les données sont converties en quelque chose d’utilisable au moment où elles sont saisies. Dans le cerveau humain, les données arrivent directement au cerveau et y sont interprétées. Comme le souligne Searle, si quelqu’un vous donne un coup de poing dans l’œil, vous “voyez des étoiles”: il s’agit d’une information traitée de manière visuelle. Aucune machine n’est truquée comme nous. Searle ne croit pas non plus qu’elle le sera un jour. Et même si c’était le cas, il pense toujours qu’il s’agirait d’une simulation et non d’une véritable conscience. Après tout, il faut bien que quelqu’un dise à l’ordinateur que s’il se cogne contre un mur, cela lui fait mal, car en réalité, lorsqu’il se cogne contre un mur, cela ne lui fait pas mal du tout. Cependant, il est concevable de construire un ordinateur mobile qui réagirait à la douleur s’il était endommagé. Nous disposons déjà d’ordinateurs qui s’analysent et se réparent eux-mêmes. Cela pourrait logiquement être étendu, mais la conscience de soi n’est qu’un aspect de la conscience.

L’auteure féministe postmoderne Kathy Acker déclare: “Lorsque la réalité - les significations associées à la réalité - est remise en question, ce qui est certainement le thème principal de Wittgenstein et l’un des problèmes centraux de la philosophie et de l’art depuis la fin du XIXe siècle, le corps lui-même devient la seule chose à laquelle on peut revenir. On peut parler de n’importe quel concept intellectuel, et c’est à n’en plus finir, parce que tout peut signifier n’importe quoi, n’importe quelle pensée peut conduire à une autre pensée et être ainsi complètement pervertie. Mais quand on en vient à l’acte physique de la sexualité, ou de la maladie corporelle, il y a une matérialité indéniable qui n’est pas à prendre en compte. C’est donc le corps qui ne peut finalement pas être touché par notre scepticisme et nos systèmes de croyance ambigus. Le corps est le seul endroit où il existe encore une base pour de vraies valeurs”.

C’est peut-être là le résumé du problème de l’esprit en tant qu’ordinateur et du corps. Au Japon, de nombreux travaux ont été réalisés pour parvenir à une cinquième génération d’ordinateurs dotés de langages naturels et de capacités d’apprentissage heuristique. Mais dans l’ensemble, ils n’ont pas réussi. “Le Japon n’a aucun avantage dans le domaine des logiciels, et rien, à moins d’un changement total de caractère national de sa part, ne changera cela de manière significative. Ce qui est vraiment remarquable au Japon, c’est la réussite de ses artisans, qui sont en fait des artistes, et qui s’efforcent de produire des biens parfaits sans se soucier du temps ou des coûts. Cet effet se manifeste également dans de nombreux projets japonais de programmation informatique à grande échelle, comme leurs travaux sur le traitement des connaissances de cinquième génération. L’équipe est tellement impliquée dans la grandeur de son concept qu’elle ne termine jamais le programme”.

Ce n’est pas seulement le problème du Japon, mais celui des informaticiens en général, qui abordent le problème dans la mauvaise direction. On ne peut pas fabriquer un cerveau, les enfants apprennent à marcher et à parler sans qu’on leur enseigne, donc tout ordinateur que les informaticiens espèrent doter d’intelligence doit avoir un programme d’apprentissage naturel. Malheureusement, on ne sait toujours pas comment les concepts de la parole sont appris et l’avenir de l’intelligence des machines semble donc peu prometteur.

Les gens attribuent souvent une “intelligence” à des objets (pour la plupart) inanimés. La voiture en est un exemple classique, mais les navires sont appelés “elle” depuis des années. Il est facile de comprendre pourquoi, lorsque l’on écrit cet essai, par exemple, et que l’on subit un “accident” qui nous fait perdre deux pages et de nombreuses heures de travail, on est susceptible de considérer la machine comme “diabolique” ou “prête à en découdre”. Ce n’est évidemment pas le cas. Cependant, comme les gens ne comprennent généralement pas ce qui se passe à l’intérieur de la “boîte à malices”, comme dans le cas de la chambre chinoise, il leur est possible d’attribuer une intelligence à une machine qui n’en a pas. C’est aussi parce que l’humanité est devenue si dépendante de la technologie que la paranoïa de la prise de contrôle du monde par les machines est apparue.

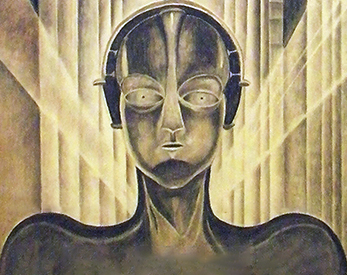

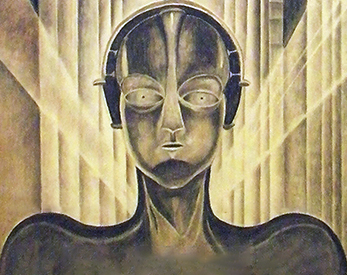

Le fait que cette paranoïa soit alimentée par des fictions cyberpunk n’arrange pas les choses. Le texte classique est “Neuromancer” de Gibson, dans lequel un réseau d’ordinateurs parvient à une intelligence unique. Cette idée est purement fictive, mais l’autre image publique est plus intéressante. Elle dérive du film “Blade Runner”, et elle est bien sûr basée sur le livre de Philip K. Dick “Les androïdes rêvent-ils de moutons électriques?”. L’un des thèmes du livre qui n’est pas entièrement représenté dans le film est l’idée de l’importance de posséder un animal. Cependant, comme il s’agit d’une société post-apocalyptique, la plupart des animaux sont morts. Bien que la possession d’un véritable animal soit récompensée, la plupart des gens se contentent d’animaux artificiels. Ils simulent volontiers les actions de moutons, de chats, de grenouilles ou autres, mais c’est tout. Ils ne pensent pas.

Le film soulève une question intéressante. À la fin, lorsque le réplicant Batty meurt, il dit: “J’ai vu des choses que vous ne croiriez pas ; des navires d’attaque en feu au large des côtes d’Orion. J’ai vu les rayons de la mer scintiller dans l’obscurité à la porte des dix maisons. Tous ces moments seront perdus dans le temps, comme des larmes sous la pluie”. Cela soulève une question philosophique: “Si un androïde doté d’un cerveau informatique peut vivre des “expériences” qu’il peut mettre en relation avec d’autres personnes, tout en étant mortel, n’a-t-il pas des droits humains inaliénables?

L’un des domaines où les simulations informatiques de l’intelligence échouent systématiquement est celui de la production de nouvelles données créatives. Dans le domaine de l’humour, par exemple. Il est probablement impossible de programmer un ordinateur pour qu’il établisse des connexions aléatoires. Cela s’explique en partie par le fait que le hasard n’existe pas. La théorie de la relativité d’Einstein peut être considérée comme s’appliquant à chaque pensée dans le cerveau humain comme ayant dérivé d’une manière ou d’une autre d’une pensée précédente ou d’un stimulus externe. Prenons un exemple qui poserait problème à un ordinateur: la blague de mauvais goût. Les ordinateurs ne savent pas ce qui est de mauvais goût parce qu’ils n’ont pas de “goût”. On peut dire à un ordinateur qu’une blague sur les minorités ethniques est de mauvais goût, mais il ne serait pas capable de trouver une nouvelle blague de son cru de même mauvais goût. D’un point de vue social, c’est une “bonne” chose, mais en termes de simulation de l’esprit humain, c’est très “mauvais”.

Enfin, nous revenons à Wittgenstein, qui résume l’ensemble de l’argumentation de Searle en disant: “Le sens n’est pas un processus qui accompagne un mot. En effet, aucun processus ne pourrait avoir les conséquences d’un sens.